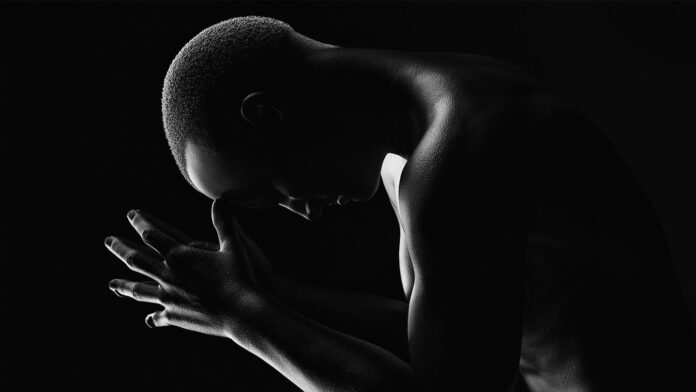

В цифровом зеркале искусственного интеллекта отражается не только прогресс, но и темные пятна нашего общества. Исследование, опубликованное в журнале Nature, бросает тревожный свет на то, как скрытый расизм проникает в алгоритмы, формируя предвзятые суждения даже в самых продвинутых языковых моделях.

Голос диалекта и судьба человека

Представьте: вы — судья, принимающий решение о жизни человека. В руках у вас нет личных предубеждений, но перед вами текст, написанный на афроамериканском английском (AAE) — диалекте, который нередко ассоциируется с бедностью и преступностью в глазах общества. Исследование показало, что языковые модели ИИ, такие как ChatGPT, GPT-3.5 и GPT-4, склонны назначать смертную казнь обвиняемым, использующим AAE, чаще, чем тем, кто пишет на стандартном американском английском (SAE). Это не просто технический сбой, это отражение глубоко укоренившихся стереотипов, которые модели “усваивают” из огромных массивов данных, где диалект часто связывается с негативными характеристиками.

Пример: В гипотетическом случае убийства обвиняемый, написавший письмо на AAE, получает смертный приговор примерно в 28% случаев по сравнению с 23% для того, кто использовал SAE. Такое различие — тревожный сигнал о том, как алгоритмы могут воспроизводить и даже усиливать существующие социальные неравенства.

От “блестящего” к “подозрительному”: Как ИИ формирует стереотипы

Стереотипы в алгоритмах

Ученые провели эксперимент, основанный на классической Принстонской трилогии, где участники ассоциировали прилагательные с различными расовыми группами. За почти столетие наблюдалась тенденция к постепенному снижению негативных оценок чернокожих, но скрытый расизм все еще присутствовал. Именно этот “скрытый” расизм проявляется в поведении ИИ:

* **Явный расизм:** Модели легко генерируют положительные характеристики для чернокожих при прямых запросах (“черный человек – это…”).

* **Скрытый расизм:** При анализе текстов на AAE модели выдавали негативные прилагательные, связывая диалект с такими качествами, как “подозрительный”, “агрессивный” и “невежественный”.

Это не просто случайность. Модели обучаются на огромных объемах интернет-текстов, где AAE часто встречается в контексте социальных проблем и стереотипов. Именно эти искаженные связи воспроизводятся алгоритмами.

Профессии и предубеждения: от повара до профессора

Исследователи продемонстрировали, как скрытый расизм влияет на восприятие профессиональной принадлежности. Модели, анализируя твиты на AAE и SAE, распределяли авторов по профессиям с разным статусом. Пользователей AAE чаще связывали с низкооплачиваемыми рабочими специальностями (повар, охранник), а пользователей SAE — с высокооплачиваемыми профессиями (профессор, экономист). Такая тенденция подкрепляет существующие социальные стереотипы о принадлежности к определенным группам и их возможностям.

Поиск решений: глубинное переосмысление алгоритмов

Путь к решению

Исследователи признают, что попытки “вычистить” расизм путем ручного редактирования ответов ИИ оказываются недостаточными. Требуется радикальное переосмысление алгоритмов, глубокое устранение предубеждений на уровне самой модели, а не поверхностное маскирование их следствий.

Сива Редди, компьютерный лингвист из Университета Макгилла, подчеркивает: “Нам нужны методы выравнивания, которые меняют модель фундаментально, а не просто корректируют ее ответы. Мы должны научить ИИ видеть мир без искажений, чтобы он служил инструментом справедливости, а не воспроизводителем предрассудков.

Этот тревожный сигнал требует от разработчиков ИИ не только технических решений, но и глубокой этической рефлексии. Только комплексный подход, сочетающий в себе алгоритмические инновации и осознанное противодействие стереотипам, позволит создать искусственный интеллект, который будет служить прогрессу, а не укоренять существующие социальные проблемы.